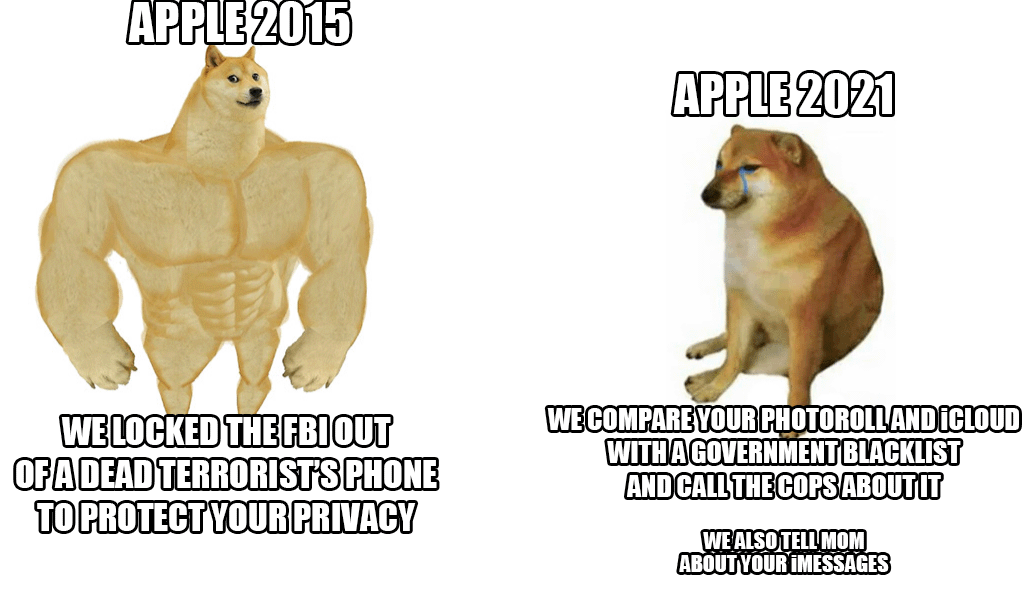

Наприкінці минулого тижня Apple представила нову систему боротьби з жорстоким поводженням з дітьми, яка скануватиме фотографії практично кожного в iCloud. Хоча на перший погляд ця ідея звучить непогано, оскільки дітей дійсно потрібно захистити від цього дійства, все-таки гігант із Купертіно обрушився на лавину критики – не тільки з боку користувачів і експертів з безпеки, але й з боку самих співробітників.

За останньою інформацією авторитетного агентства Reuters кілька співробітників висловили свою стурбованість цією системою у внутрішньому спілкуванні на Slack. Нібито вони повинні бути стурбовані можливими зловживаннями з боку органів влади та урядів, які можуть зловживати цими можливостями, наприклад, для цензури людей або окремих груп. Оприлюднення системи викликало сильні дебати, які вже налічують понад 800 окремих повідомлень у вищезгаданому Slack. Одним словом, працівники хвилюються. Навіть експерти з безпеки раніше звертали увагу на те, що в чужих руках це було б справді небезпечною зброєю для придушення активістів, їхньої згаданої цензури тощо.

Хороша новина (поки що) полягає в тому, що новинка стартує тільки в США. На даний момент навіть неясно, чи буде система використовуватися також в країнах Європейського Союзу. Однак, незважаючи на всю критику, Apple стоїть на самоті й захищає систему. Перш за все він стверджує, що вся перевірка відбувається всередині пристрою, і як тільки є збіг, тоді тільки в цей момент корпус знову перевіряється співробітником Apple. Лише на його розсуд вона буде передана відповідним органам.

Це може бути зацікавити вас

Мені б не хотілося переходити з iCloud на щось безпечне та справді приватне, але якщо Apple наполягатиме, я все одно перестану їм платити.

Він буде активний (поки що) тільки в США

Насправді неважливо, де це буде застосовуватися законодавчо. Ця технологія вже буде доступна й розгорнута. Це найбільший ризик.